OpenAI 和 ChatGPT展现了强大的能力,也引起很多人提出哲学性的问题:AI究竟算不算真正的智能?他跟人类智能有啥区别。

我认为,现在对AI做这种形而上的哲学性的讨论都是虚的,没有意义。

我的答案很肯定:从哲学上说,AI当然可以产生智能。

我们先思考下人类智能是怎么来的。一个人是通过掌握一个概念的各种属性,来形成自己对世界的理解的。比如“马”这个概念拥有很多属性,马是哺乳动物,有四条腿,生活在草原,古有汗血宝马,马中赤兔人中吕布,欧洲有穿着铁甲的马……我们又习得下一个概念:牛也是哺乳动物,我们知道牛和马在生物学上有很多相似之处,但在人文属性上就不一定相似,我们知道牛也有四条腿,但不会认为古代吕布也骑牛。我们习得下个概念:鲸鱼长得像鱼,但属于哺乳动物,我们知道在哺乳动物这个类别中,鲸鱼和马的相似度,就远远不如牛和马的相似度。人类对世界的理解,就建立在对不同概念相似性类比和不相似性对比之上,这些概念与概念交织起的网络,就形成了对事物理解,能够举一反三,从而形成了人类智能。

传统构建机器智能的方式,就是尽可能枚举出所有的属性,然后hard code告诉机器。

这种枚举法存在不少有问题,最简单的一件事情,同为哺乳动物,马和牛更相似,而鲸鱼相对差别大些,但枚举法体现不出这样的亲疏远近。我们可以改良一下,把属性值从文字变成数字,比如用0-100的动物进化分来代表低级到高级的动物,0分表示最低级的单细胞生物,100分表示最高级的哺乳动物人类,那么牛和马的动物类别属性可以表示为90分,鲸鱼表示为80分,大于80分的都是哺乳动物;金鱼表示为78分,这样我们就知道了不同概念之间的相似的亲疏,虽然鲸鱼属于哺乳动物,但它跟金鱼更相似。

改良后的枚举法还是有问题,稳定性很差。按照动物进化的理论,鸟类比起鱼类在动物进化树上更高级,鸟类的得分应当比金鱼高,比哺乳动物低,也就是79分;但这又意味着,鲸鱼80分和鸟类79分的相似度,比鲸鱼和鱼类的相似度更高,这显然是矛盾的。

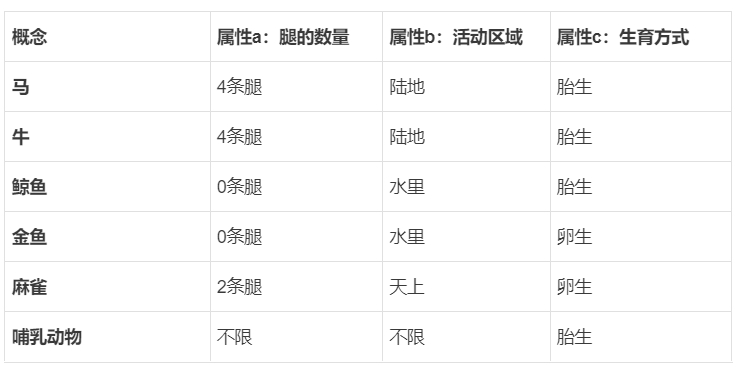

这个矛盾在一维的标尺下是无解的,所以“动物类别”就不能只是一种一维变量。我们需要进一步把“动物类别”这个属性拆分为子属性,比如属性a是腿的数量,属性b是活动区域,属性c是生育方式……这样多维变量来描述一个事情,会更立体。

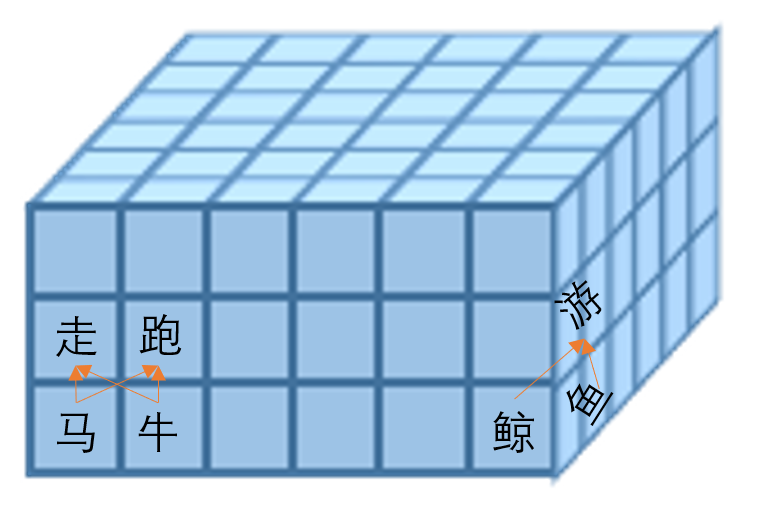

以上只是在一个二维平面上分析了并列名词之间的关系,那么还需要另外一套完整的表格来表达主语和动作之间的关系。比如马会跑,鱼会游,鸟会飞。在这一套表里面,马和跑的属性a的取值是接近的,马和飞的属性a的取值是不同的……以此类推。这样一层一层叠加,好像魔方一样,相关的概念被转到相邻格子,形成知识网络,量变带来质变,我们人类才能对一个概念形成完整、全面、立体的理解。这其实也是很多人教小孩子的方法,下定义。学习就是把教材里的内容记下来,成为了你的知识;对一个事物从不同的角度了解它,就会加深对这个事物的理解。知识不等于智能,如果不能举一反三,那就不算真正理解了。

现在大语言模型都用的是Transformer架构,就是这个理念。我不想引述2017年 Attention is All You Need 这篇知名的谷歌论文的内容,我想用一种更比喻性(但可能丧失一些严谨性)的方式来解释下。

Transformer架构,把每个单词视为一个token,每个token用H维的向量来表示其内在属性的相似度,叠加L层Transformer层来表示关系的相似度。总的参数规模就是 token数量*向量维度数 * 层数。造句时,把相似度比较高的概念连起来,最终的生成语言,看起来似乎对世界有了理解。(“牛马会跑,鲸鱼会游。”)

谷歌的DeepMind最近在其官方的pexels账号中上传了一段动画视频,“简单明了地”演示了大语言模型的工作原理。DeepMind做的动画比我手画的好看很多,但我相信还是需要我上文“简单明了的”文字解释。

从GPT1到GPT4到BERT,到国内的文心一言百川大模型,都是Transformer架构,大家在算法上都没有什么差别,就是往上堆隐向量维度数和层数。从GPT3开始,才涌现了一定的智能,这几个参数的量级,恰好跟现实事物在数量级上对应上了。Token的数量代表的概念的数量。GPT1和2只用了2万个 token,因为英语词典里常用的单词就这么多。实际上一个单词并不是最低的概念单元,还有不少复合词,GPT3扩展到15万个,这个跟人类能掌握的概念数量差不多了。其次是总的参数规模,这跟人类神经元处理数据的方式很类似。人类的神经元大概就是1000亿个,这才足够形成智能,猴子的神经元大约有60亿个,有点智能但不够。GPT3的1750亿参数规模,达到甚至超过人类的神经元的数量,这才有可能涌现出智能。GPT2只有15亿,考虑到机器运算的效率还不如神经元这种精妙的电化学机器,没能达到产生智能的临界点也能理解了。

这就论证了机器智能和人类智能之间也许就是相通的,并不存在理论上的鸿沟。人类智能现在只有一个能量转化效率上的优势,只要一点点米饭提供的能量(一个22岁的本科生从他出生到毕业只需要消耗10000千克食物,满打满算吃掉40万人民币的食物好了),就达到机器用几万张显卡这么多度电花费几百亿人民币才能算出来的结果,这转化效率是10万倍。但是机器只要堆参数量、堆电力,并非不可能堆出一个比普通人还聪明的智能体。这种哲学性而不精确的讨论到此为止就够了,不需要再去思考AI究竟差在哪里。有人说AI有幻觉(Hallucination),会一本正经地胡说八道。这话说的,人类就不会么。去看看人类考生考卷上的回答,多少啼笑皆非的答案,把老师和家长气得冒烟。把人类按在一个就算你不懂也得瞎鸡巴写点啥答案的场合下,那也会把人逼得胡说八道。

发表回复